Evolución de las infraestructuras de TI: Un viaje a través de su historia

La evolución de la arquitectura tecnológica ha sido crucial en el desarrollo y optimización de las infraestructuras de TI. Exploramos la transición desde servidores dedicados hasta la virtualización y la containerización.

La evolución de la arquitectura tecnológica ha sido crucial en el desarrollo y optimización de las infraestructuras de TI. En las últimas décadas, hemos presenciado la transición desde servidores dedicados hasta la virtualización y la containerización. Cada una de estas etapas ha traído consigo mejoras significativas en eficiencia, flexibilidad y escalabilidad, habilitando las aplicaciones y servicios que las empresas necesitan para prosperar en la era digital.

Entender esta evolución es clave para mantener la competitividad y anticiparse a los desafíos del futuro.

Servidores dedicados

Los pilares de la infraestructura tradicional

“El servidor adecuado para el trabajo adecuado.” - Bob Muglia

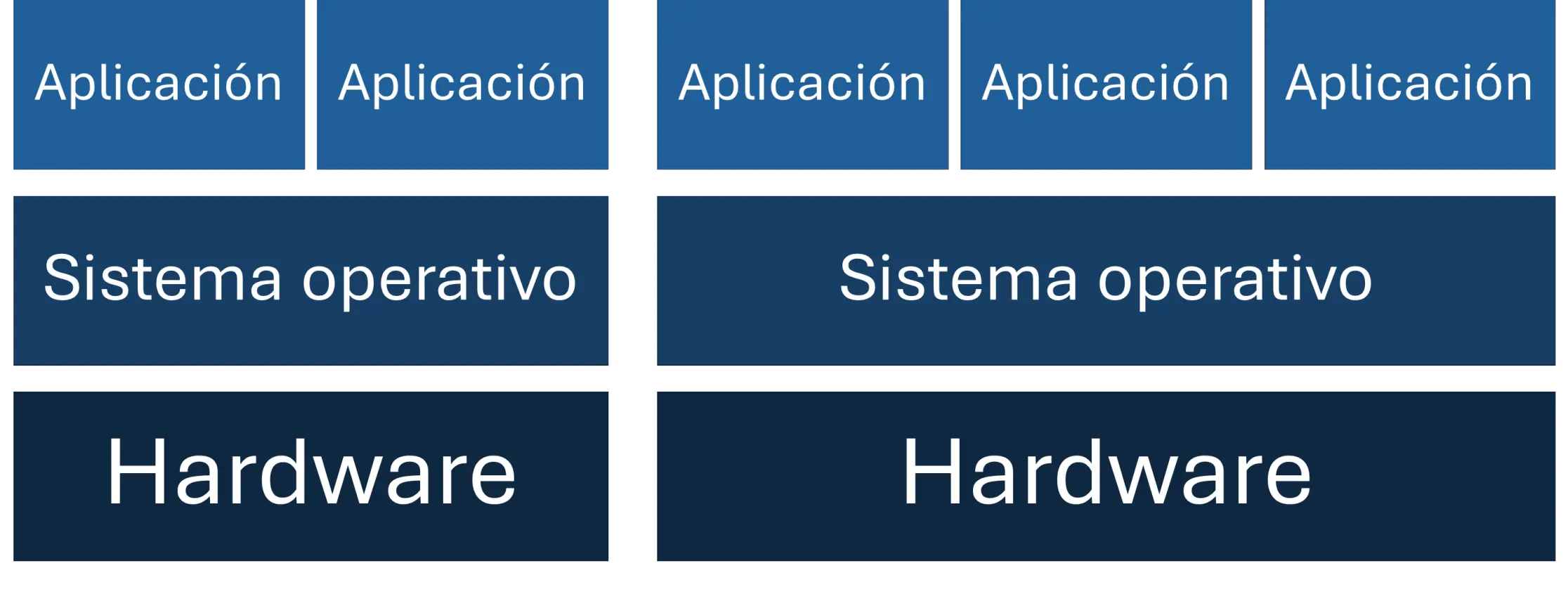

Durante los primeros años de la computación empresarial, los servidores dedicados fueron la primera opción disponible para las empresas. Estos servidores físicos se utilizaban para alojar aplicaciones críticas, bases de datos y servicios web, donde cada aplicación o servicio operaba en un servidor físico exclusivo, proporcionando un alto nivel de rendimiento y confiabilidad. La arquitectura de servidores dedicados permitió que las empresas tuvieran el control total sobre sus recursos, lo que era esencial para mantener un entorno de trabajo seguro y predecible.

Figura 1. Diagrama de arquitectura tradicional basada en servidores dedicados

Figura 1. Diagrama de arquitectura tradicional basada en servidores dedicados

Ventajas

-

Rendimiento y estabilidad: Al estar reservados exclusivamente para una única aplicación o servicio, proporcionan un entorno optimizado que maximiza el rendimiento y permiten una experiencia consistente y predecible.

-

Alto nivel de seguridad: Los servidores dedicados ofrecen un aislamiento físico total, lo que significa que todos los recursos de la máquina son exclusivos para un solo cliente o usuario.

-

Control total del hardware: El control exclusivo del hardware es una ventaja crítica para muchas empresas, ya que permite una personalización profunda en la configuración del servidor. Se puede elegir el procesador, memoria, almacenamiento y red más adecuados para las necesidades de la empresa, garantizando un dimensionamiento alineado con sus objetivos específicos.

Desventajas

-

Altos costos: La inversión inicial para adquirir servidores físicos y el mantenimiento continuo representa una barrera significativa para muchas empresas. Además de los costos de hardware, también se incurre en gastos relacionados con el espacio físico, sea en un centro de datos o en sitio.

-

Escalabilidad limitada: Es necesario adquirir más hardware cuando se requiere mayor capacidad, lo cual no solo es costoso, sino también lento. Además, no es posible ajustar los recursos de manera dinámica de acuerdo a las demandas fluctuantes.

-

Limitaciones en disponibilidad: Garantizar la alta disponibilidad era un desafío, ya que la infraestructura dependía de servidores físicos únicos. Las fallas de hardware podrían resultar en tiempos de inactividad prolongados, y la implementación de redundancia era costosa.

Aunque los servidores dedicados siguen siendo una solución válida en ciertas situaciones, especialmente para aplicaciones que requieren un alto rendimiento y segmentación, su limitante en cuanto a costos y escalabilidad impone la búsqueda de alternativas más eficientes.

Virtualización

Maximizando la utilización y flexibilidad

“La virtualización es como una navaja suiza. Puedes usarla en…” - Raghu Raghuram

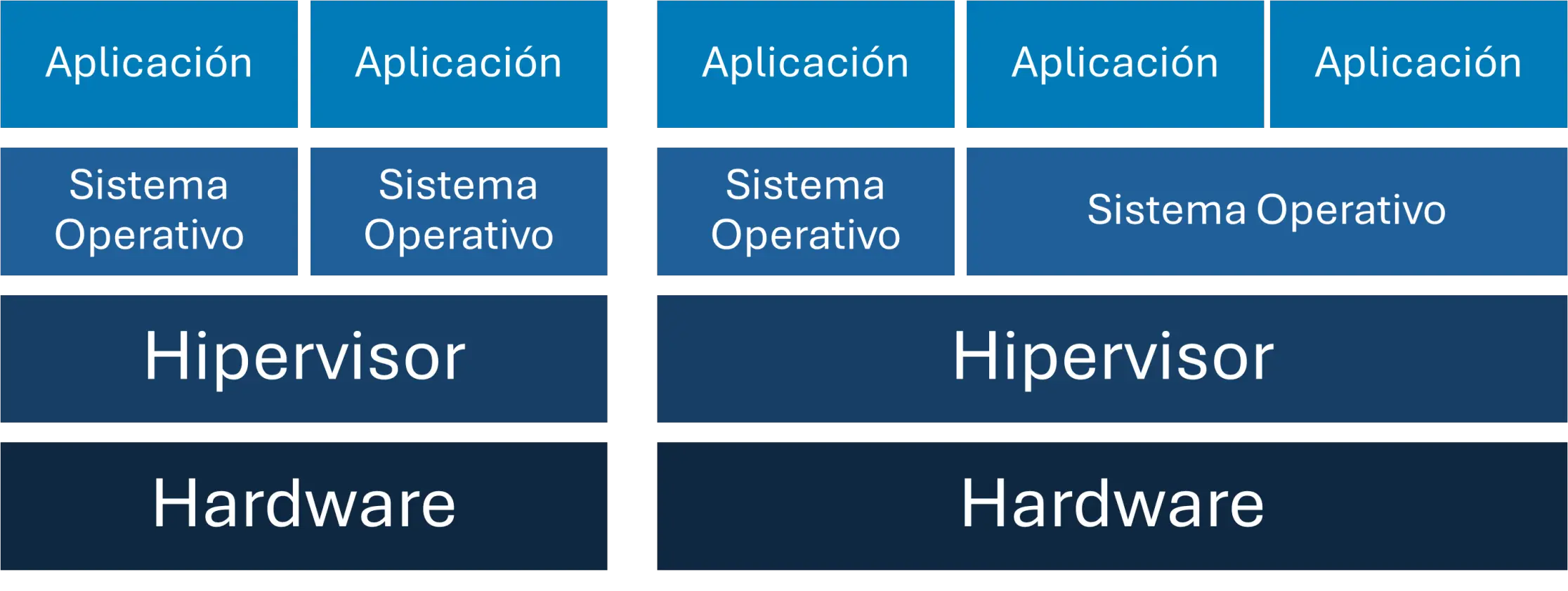

La virtualización (en arquitectura x86), introducida comercialmente por VMware a finales de los años 90, revolucionó la gestión de recursos de hardware al permitir que múltiples máquinas virtuales (VMs) se ejecutaran en un solo servidor físico. Se utiliza un software llamado hipervisor, que se sitúa entre el hardware físico y los sistemas operativos, gestionando y distribuyendo los recursos entre las VMs, de modo que cada una funcione como si tuviera su propio hardware dedicado. Esto mejoró la utilización de recursos y redujo significativamente los costos operativos.

Hipervisores comerciales como VMware ESXi, Citrix XenServer y Microsoft Hyper-V permitieron a las empresas consolidar servidores, mejorar la redundancia y simplificar la gestión del hardware. Asimismo, tecnologías de código abierto como KVM (Kernel-based Virtual Machine) y plataformas de gestión como Proxmox han jugado un papel crucial en la democratización de la virtualización.

Figura 2. Diagrama de arquitectura basada en virtualización

Figura 2. Diagrama de arquitectura basada en virtualización

Ventajas

-

Optimización de recursos: La virtualización permite ejecutar múltiples máquinas virtuales (VMs) en un solo servidor, aprovechando al máximo el hardware disponible, lo que reduce costos y mejora la eficiencia.

-

Escalabilidad: Es posible crear, clonar o mover VMs con facilidad, además de expandir o reducir sus recursos según las necesidades cambiantes de la empresa.

-

Resiliencia: Las plataformas de virtualización ofrecen recuperación automática y alta disponibilidad, minimizando los tiempos de inactividad al mover cargas de trabajo entre servidores en caso de fallo.

Desventajas

-

Dependencia del hipervisor: A pesar de ser mínimo, el rendimiento puede verse afectado debido a la capa adicional del hipervisor, que gestiona los recursos entre VMs.

-

Sobrecarga de recursos: Aunque optimiza el hardware, ejecutar múltiples VMs en un solo servidor puede sobrecargar los recursos y afectar el rendimiento si la infraestructura no está dimensionada adecuadamente.

-

Seguridad compartida: El entorno subyacente es compartido entre las VMs, lo que puede ser un riesgo en caso de vulnerabilidades en el hipervisor, aunque las VMs están aisladas entre sí.

La virtualización allanó el camino para el desarrollo de infraestructuras de nube privada, pública e híbrida, donde los recursos de TI son escalables de manera dinámica según la demanda.

Containerización

La revolución de la portabilidad y escalabilidad

“Nuestra industria no respeta la tradición, solo respeta la…” - Satya Nadella

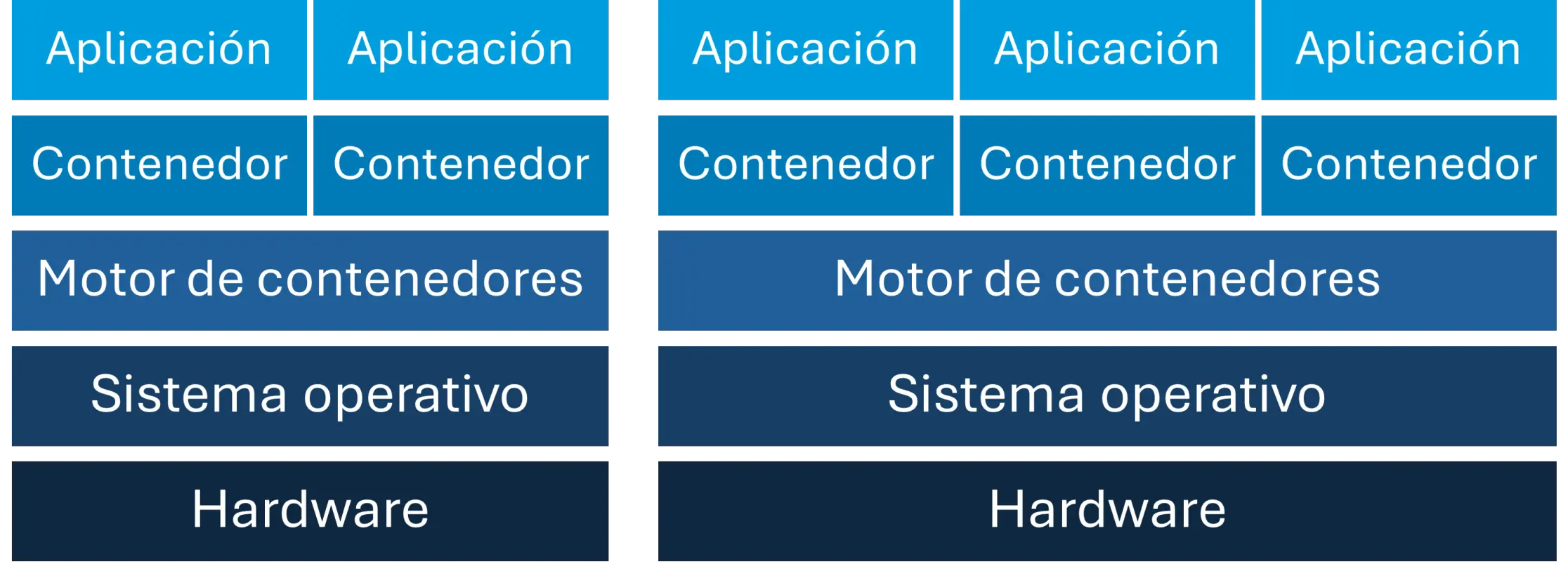

El siguiente gran avance en infraestructura tecnológica es la containerización, popularizada por Docker a mediados de la década de 2010. La containerización ha transformado de manera significativa la forma en que se desarrollan, despliegan y gestionan las aplicaciones modernas.

Los contenedores funcionan a través de la creación de una imagen, que contiene la aplicación y todas sus dependencias. Esta imagen actúa como una plantilla inmutable que puede ser utilizada para generar instancias de contenedores. Al ejecutar la aplicación, el contenedor se instancia a partir de la imagen almacenada en un registro de contenedores y se ejecuta en un entorno aislado utilizando los recursos del sistema operativo anfitrión. El aislamiento y el control de recursos se logran mediante características del sistema operativo, como los namespaces y cgroups, lo que garantiza que cada contenedor funcione de manera independiente, incluso en un mismo servidor.

Kubernetes, una plataforma de orquestación de contenedores diseñado inicialmente por Google, ha llevado la gestión de contenedores a un nuevo nivel, permitiendo desplegar, gestionar y escalar aplicaciones sobre contenedores en clústeres distribuidos con facilidad. Kubernetes no solo automatiza la implementación y el escalado de aplicaciones, sino que también gestiona la recuperación ante fallos, el equilibrio de carga y la supervisión continua, lo que garantiza un rendimiento óptimo y una alta disponibilidad.

Figura 3. Diagrama de arquitectura basada en contenedores

Figura 3. Diagrama de arquitectura basada en contenedores

Ventajas

-

Eficiencia: Los contenedores son significativamente más ligeros que las máquinas virtuales, ya que comparten el mismo núcleo del sistema operativo subyacente, lo que permite iniciar y detener aplicaciones rápidamente.

-

Portabilidad: Los contenedores son fáciles de desplegar en distintos entornos de desarrollo, prueba y producción, lo que simplifica la implementación en múltiples plataformas.

-

Escalabilidad horizontal: Los contenedores se pueden replicar y escalar rápidamente, permitiendo manejar picos de demanda de forma eficiente.

Desventajas

-

Aislamiento limitado: A diferencia de las VMs, los contenedores comparten el mismo kernel que sistema operativo anfitrión, lo que puede representar un riesgo de seguridad si un contenedor compromete el sistema.

-

Persistencia de datos compleja: La gestión de datos en contenedores puede ser desafiante, especialmente en arquitecturas de contenedores efímeros que no mantienen datos a largo plazo.

-

Complejidad de administración: Gestionar grandes volúmenes de contenedores puede volverse complejo, lo que requiere herramientas de orquestación (como Kubernetes) y habilidades técnicas avanzadas.

La adopción de contenedores ha impulsado la popularidad de los microservicios, un enfoque arquitectónico que divide aplicaciones complejas en pequeños servicios independientes, facilitando su desarrollo, despliegue y escalabilidad.

Mirando hacia el futuro

“La mejor forma de predecir el futuro es inventarlo.” - Alan Kay

A medida que avanzamos, la convergencia de estos paradigmas de infraestructura TI, junto con la incorporación de tecnologías emergentes como la inteligencia artificial y la computación de borde, está redefiniendo los estándares de infraestructura en la era digital, impulsando la creación de sistemas más ágiles, inteligentes y capaces de adaptarse rápidamente a entornos de mayor demanda.

Con la inteligencia artificial, los sistemas de infraestructura IT serán capaces de anticipar necesidades y adaptarse a nuevas cargas de trabajo sin intervención humana. De manera similar, la computación de borde permitirá que los datos sean procesados más cerca de la fuente, mejorando la latencia y optimizando el uso de la red.

Figura 4. Innovación en la infraestructura TI: La convergencia de la inteligencia y la tecnología

Figura 4. Innovación en la infraestructura TI: La convergencia de la inteligencia y la tecnología

La innovación tecnológica no es solo una ventaja competitiva, sino una necesidad para cualquier organización que aspire a liderar en su sector. Aquellas empresas que adopten estas tecnologías y optimicen su infraestructura estarán mejor preparadas para aprovechar las oportunidades del futuro y responder a los desafíos que plantea la transformación digital. Con este enfoque, la evolución de las arquitecturas tecnológicas seguirá siendo el motor que impulse el crecimiento y la resiliencia organizacional en los años venideros.

¿Necesitas ayuda para modernizar tu infraestructura? Contáctame para una evaluación de tu entorno actual.